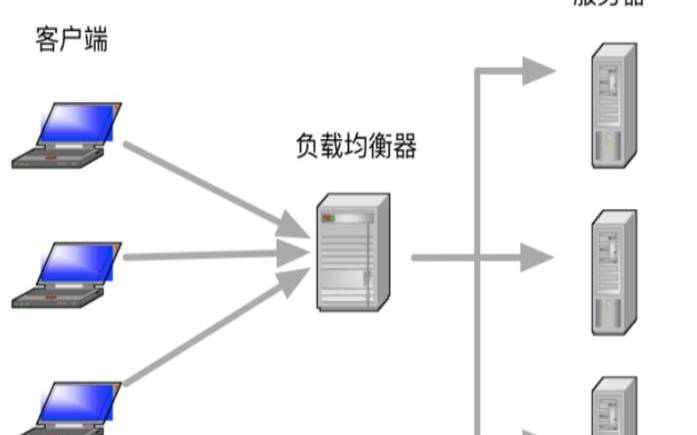

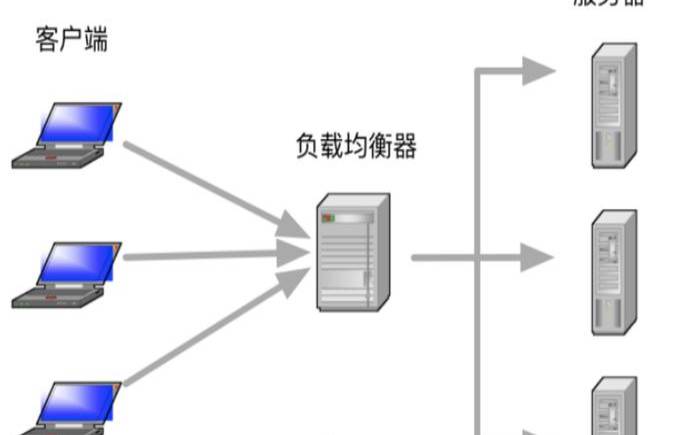

随着互联网的迅速发展,美国Web服务器面临着越来越大的压力,需要处理大量的网络流量和用户请求。为了提高服务器性能和可靠性,负载均衡成为一种不可或缺的策略。本文将深入探讨美国Web服务器负载均衡的概念,以及如何实现高效的负载均衡。

提高性能:负载均衡可以将客户端请求均匀地分配到多个服务器上,避免单个服务器过载,从而提高整体性能和响应速度。

提高可靠性:通过将流量分散到多个服务器上,负载均衡可以降低服务器故障对用户的影响,提高系统的可靠性和容错性。

实现可伸缩性:负载均衡可以根据实际需求自动调整服务器资源的分配,以适应不断增长的用户访问量和流量。

软件负载均衡器:通过在服务器之间运行软件来实现负载均衡。常见的软件负载均衡器包括Nginx、Apachemod_proxy_balancer等。软件负载均衡器成本较低,但可能存在性能瓶颈。

DNS负载均衡:通过DNS服务器将客户端请求分发到不同的服务器IP地址,以实现负载均衡。这种方法简单易用,但无法动态调整负载分配。

轮询算法:按照顺序将请求分发给服务器,均匀分配负载。适用于服务器配置相同且负载平衡要求不高的场景。

最少连接算法:将请求分发给当前连接数最少的服务器,以确保每个服务器的负载相对均衡。适用于处理长连接的场景。

响应时间算法:根据服务器的响应时间来分配请求,将请求发送到响应时间较短的服务器上,以提高用户体验。

负载均衡是提高美国Web服务器性能和可靠性的关键策略。通过硬件负载均衡器、软件负载均衡器或DNS负载均衡等方法实现负载均衡,并选择适合的算法,可以优化服务器资源利用率、提高响应速度,并实现服务器的可伸缩性。在实际应用中,还需要根据具体需求和预算选择合适的负载均衡解决方案。

本文来源:国外服务器--web服务器负载架构(服务器负载均衡如何实现)

本文地址:https://www.idcbaba.com/guowai/389.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 1919100645@qq.com 举报,一经查实,本站将立刻删除。